Біологічна нейронна мережа

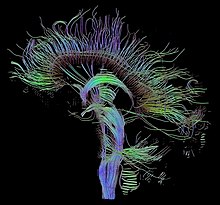

Нейронна мережа (біологічна нейронна мережа, БНМ) — сукупність нейронів головного і спинного мозку центральної нервової системи (ЦНС) і ганглій периферичної нервової системи (ПНС), які пов'язані або функціонально об'єднані за допомогою синапсів в нейронні ланцюги, що утворюють ансамблі, які об'єднуються в системи та виконують специфічні фізіологічні функції.[1][2][3]

Нейронна мережа складається з групи нейронних ланцюгів — груп мофро-функціонально пов'язаних нейронів. Один нейрон може бути пов'язаний із багатьма іншими нейронами за допомогою нейронних відростків — довгих аксонів та коротких розгалуджених дендритів. З загальна кількість нейронів і зв'язків в мережі може бути достатньо великим, наприклад, мозок людини містить до 100 мільярдів нейронів[4] і кожен нейрон може з'єднуватись з великою кількістю, до 10 000, інших нейронів, передаючи сигнали один одному через 1000 трильйонів синапсів.[5] Місце контакту нейронів називається синапсом, типовий синапс — аксо-дендричний хімічний. Передача імпульсів здійснюється хімічним шляхом за допомогою нейромедіаторів або електричним шляхом за допомогою проходження іонів з однієї клітини в іншу.

Уявлення про нейронні мережі справило значний вплив на технології штучного інтелекту, завдяки спробі побудувати математичну модель нейронної мережі було створено великий інструментарій штучних нейронних мереж, який широко використовується в прикладній математиці та інформатиці. За деякими оцінками звичне функціонування головного мозку еквівалентно комп’ютеру з процесором 1 трильйон біт на секунду. Оцінки об’єму пам’яті людського мозку варіюються від 1 до 1000 терабайт.[5]

Історія

ред.Перші згадки про нейронні мережі помічені у Бейна[6] (1873) та Джеймса[7] (1890) — у своїх роботах вони розглядають розумову діяльність як результат взаємодії між нейронами головного мозку.

Згідно з Бейном, будь-яка діяльність веде до активізації певного набору нейронів. При повторенні тієї ж діяльності зв'язок між цими нейронами зміцнюються. Згідно з його теорією, ці повторення ведуть до формування пам'яті. Наукове співтовариство того часу сприйняло теорію скептично, оскільки її наслідком було виникнення надмірної кількості нейронних зв'язків у мозку. Тепер очевидно, що мозок є надзвичайно складною конструкцією і здатний працювати з декількома завданнями одночасно.

Теорія Джеймса була схожа з теорією Бейна, але в той же час Джеймс припустив, що формування пам'яті відбувається в результаті проходження електричного струму між нейронами в головному мозку, не вимагаючи з'єднань нейронів для кожного акту запам'ятовування або дії.

Британський фізіолог Шеррінгтон у 1898 році провів експерименти для перевірки теорії Джеймса[8], в яких пропускав електричний струм уздовж спинного мозку щурів. При цьому замість очікуваного посилення струму, відповідно до теорії Джеймса, Шеррінгтон виявив, що електричний струм слабшає з плином часу. Результати експериментів Шеррінгтона зіграли важливу роль у розробці теорії звикання (габітуації).

У 1949 році Дональд Гебб стверджував, що нейронні зв'язки не є статичними — їх можна покращувати кожного разу, коли вони активуються. Ця гіпотеза відома як «правило Гебба». Воно передбачає, що процес навчання не є результатом фіксованої властивості нейронів; це залежна від часу функція їх змінних зв'язків. Основна ідея, яка лежить в основі правила Гебба, полягає в тому, що скупчення нейронів мають тенденцію збуджуватися разом, коли сприймається подразник. Їх коливальна активність може тривати і після припинення дії подразника. Таким чином, подія, яка спричинила одночасне коливання групи нейронів, фіксується в пам’яті у вигляді групи синхронізованих нейронів.[9]

Біологічні та штучні нейронні мережі

ред.Штучні нейронні мережі (ШНМ) досягли великих успіхів за останні роки, підштовхнувши штучний інтелект до того, щоб перевершити людський мозок у багатьох конкретних завданнях, таких як гра в шахи та го[10], відеоігри[11], медична діагностика[12] тощо. Незважаючи на це, коли мова йде про більш загальні та більш абстрактні завдання, що вимагають адаптивного навчання та пізнання, людський мозок демонструє кращу продуктивність. За допомогою мозку люди можуть сприймати, розуміти, адаптуватися до навколишнього середовища та активно змінювати його. Порівняно з ШНМ, БНМ все ще мають переваги в багатьох аспектах[13]:

- вища енергоефективність

- паралельні обчислення

- навчання в реальному часі

- самовідновлення

- автономна свідомість (активне пізнання) тощо.

Ці характеристики БНМ значною мірою виграють від природи біологічних нейронів і їх мереж в обробці інформації.[14] Нейрон, основна одиниця БНМ, обробляє інформацію, запускаючи потенціали дії (ПД; або спайки) відповідно до свого мембранного потенціалу (різниця між внутрішнім і зовнішнім потенціалами нейрона) за принципом «усе або нічого»: коли його мембранний потенціал перевищує поріг спрацьовування знизу, нейрон запускає ПД. Крім того, синапс з’єднує 2 нейрони, завдяки чому ПД, що випромінює пресинаптичний нейрон, викликає зміну мембранного потенціалу постсинаптичного нейрона, таким чином сигнал передається від пресинаптичного нейрона до постсинаптичного нейрона. Крім того, сила синапсів адаптивно змінюється у відповідь на вхідні сигнали та відповіді постсинаптичних нейронів, які, як вважають, лежать в основі нейропластичності — здатності мозку навчатися та зберігати спогади[15].

Див. також

ред.Додаткова література

ред.Книги

ред.- Ronald J. MacGregor (2012). Theoretical Mechanics of Biological Neural Networks (англ.). Elsevier Science. с. 377. ISBN 9780080924410.

- Karl H. Pribram (2014). Rethinking Neural Networks: Quantum Fields and Biological Data (англ.). Taylor & Francis. с. 564. ISBN 9781317780953.

- Peter Robin Hiesinger (2022). The Self-Assembling Brain: How Neural Networks Grow Smarter (англ.). Princeton University Press. с. 384. ISBN 9780691241692.

- Edmund T. Rolls (2023). Brain Computations and Connectivity. Oxford: Oxford Centre for Computational Neuroscience, Oxford University Press. ISBN 978–0–19–888791–1.

Журнали

ред.Статті

ред.- Підбірка статей Neural circuits (Nature Portfolio)

- Barrett, David GT; Morcos, Ari S; Macke, Jakob H (2019). Analyzing biological and artificial neural networks: challenges with opportunities for synergy?. Current Opinion in Neurobiology (англ.) 55. с. 55–64. doi:10.1016/j.conb.2019.01.007.

- Pircher Thomas; Pircher Bianca; Schlücker Eberhard; Feigenspan Andreas (2021). The structure dilemma in biological and artificial neural networks. Scientific Reports (англ.) 11 (1). doi:10.1038/s41598-021-84813-6.

- Powell Henry; Winkel Mathias; Hopp Alexander V.; Linde, Helmut (2022). A hybrid biological neural network model for solving problems in cognitive planning. Scientific Reports (англ.) 12 (1). doi:10.1038/s41598-022-11567-0.

- Suhaimi Ahmad; Lim Amos W. H.; Chia Xin Wei; Li Chunyue; Makino Hiroshi (2022). Representation learning in the artificial and biological neural networks underlying sensorimotor integration. Science Advances (англ.) 8 (22). doi:10.1126/sciadv.abn0984.

- Smirnova Lena; Caffo Brian S. та ін. (2023). Organoid intelligence (OI): the new frontier in biocomputing and intelligence-in-a-dish. Frontiers in Science (English) 0. doi:10.3389/fsci.2023.1017235.

- Chen Zhe; Liang Qian; Wei Zihou; Chen Xie; Shi Qing; Yu Zhiqiang; Sun Tao (2023). An Overview of In Vitro Biological Neural Networks for Robot Intelligence. Cyborg and Bionic Systems (англ.) 4. doi:10.34133/cbsystems.0001.

- Seguin Caio; Sporns Olaf; Zalesky Andrew (12 липня 2023). Brain network communication: concepts, models and applications. Nature Reviews Neuroscience (англ.). с. 1–18. ISSN 1471-0048. doi:10.1038/s41583-023-00718-5.

Примітки

ред.- ↑ Ronald J. MacGregor (2012). Theoretical Mechanics of Biological Neural Networks (англ.). Elsevier Science. с. 377. ISBN 9780080924410.

- ↑ Karl H. Pribram (2014). Rethinking Neural Networks: Quantum Fields and Biological Data (англ.). Taylor & Francis. с. 564. ISBN 9781317780953.

- ↑ Peter Robin Hiesinger (2022). The Self-Assembling Brain: How Neural Networks Grow Smarter (англ.). Princeton University Press. с. 384. ISBN 9780691241692.

- ↑ Herculano-Houzel, Suzana (2009). The human brain in numbers: a linearly scaled-up primate brain. Frontiers in Human Neuroscience. Т. 3. doi:10.3389/neuro.09.031.2009. ISSN 1662-5161. PMC 2776484. PMID 19915731. Процитовано 28 червня 2023.

{{cite news}}: Обслуговування CS1: Сторінки з PMC з іншим форматом (посилання) Обслуговування CS1: Сторінки із непозначеним DOI з безкоштовним доступом (посилання) - ↑ а б Zhang, Jiawei (2019). Basic Neural Units of the Brain: Neurons, Synapses and Action Potential. doi:10.48550/ARXIV.1906.01703. Процитовано 28 червня 2023.

- ↑ Bain (1873). Mind and Body: The Theories of Their Relation. New York: D. Appleton and Company.

- ↑ James (1890). The Principles of Psychology. New York: H. Holt and Company.

- ↑ Sherrington, C.S. Experiments in Examination of the Peripheral Distribution of the Fibers of the Posterior Roots of Some Spinal Nerves. Proceedings of the Royal Society of London. 190: 45—186.

- ↑ HEBB, D.O. (1949). The Organization of Behavior: a Neuropsychological Theory (eng) . New York: JOHN WILEY & SONS, Inc.; London: CHAPMAN & HALL, Limited.

- ↑ Silver, David; Schrittwieser, Julian; Simonyan, Karen; Antonoglou, Ioannis; Huang, Aja; Guez, Arthur; Hubert, Thomas; Baker, Lucas; Lai, Matthew (2017-10). Mastering the game of Go without human knowledge. Nature (англ.). Т. 550, № 7676. с. 354—359. doi:10.1038/nature24270. ISSN 1476-4687. Процитовано 28 червня 2023.

- ↑ Vinyals, Oriol; Babuschkin, Igor; Czarnecki, Wojciech M.; Mathieu, Michaël; Dudzik, Andrew; Chung, Junyoung; Choi, David H.; Powell, Richard; Ewalds, Timo (2019-11). Grandmaster level in StarCraft II using multi-agent reinforcement learning. Nature (англ.). Т. 575, № 7782. с. 350—354. doi:10.1038/s41586-019-1724-z. ISSN 1476-4687. Процитовано 28 червня 2023.

- ↑ Mei, Xueyan; Lee, Hao-Chih; Diao, Kai-yue; Huang, Mingqian; Lin, Bin; Liu, Chenyu; Xie, Zongyu; Ma, Yixuan; Robson, Philip M. (2020-08). Artificial intelligence–enabled rapid diagnosis of patients with COVID-19. Nature Medicine (англ.). Т. 26, № 8. с. 1224—1228. doi:10.1038/s41591-020-0931-3. ISSN 1546-170X. PMC 7446729. PMID 32427924. Процитовано 28 червня 2023.

{{cite news}}: Обслуговування CS1: Сторінки з PMC з іншим форматом (посилання) - ↑ Chen, Zhe; Liang, Qian; Wei, Zihou; Chen, Xie; Shi, Qing; Yu, Zhiqiang; Sun, Tao (2023-01). An Overview of In Vitro Biological Neural Networks for Robot Intelligence. Cyborg and Bionic Systems (англ.). Т. 4. doi:10.34133/cbsystems.0001. ISSN 2692-7632. PMC 10076061. PMID 37040493. Процитовано 28 червня 2023.

{{cite news}}: Обслуговування CS1: Сторінки з PMC з іншим форматом (посилання) - ↑ Marois, René; Ivanoff, Jason (2005-06). Capacity limits of information processing in the brain. Trends in Cognitive Sciences. Т. 9, № 6. с. 296—305. doi:10.1016/j.tics.2005.04.010. ISSN 1364-6613. Процитовано 28 червня 2023.

- ↑ Bear, Mark F.; Connors, Barry W.; Paradiso, Michael A. (2016). Neuroscience: exploring the brain (вид. Enhanced fourth edition). Burlington, MA: Jones & Bartlett Learning. ISBN 978-1-284-21128-3.

В іншому мовному розділі є повніша стаття Biological neural network(англ.). Ви можете допомогти, розширивши поточну статтю за допомогою перекладу з англійської.

|

| Це незавершена стаття з нейронауки. Ви можете допомогти проєкту, виправивши або дописавши її. |