Регресія Демінга

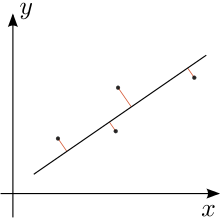

У статистиці регресія Демінга (названа на честь В. Едвардса Демінга) є моделлю з похибками у змінних, яка намагається знайти лінію, яка найкраще підходить для двовимірного набору даних. Вона відрізняється від простої лінійної регресії тим, що пояснює похибку в спостереженнях як на осі x, так і на осі y. Це особливий випадок загальних найменших квадратів, що дозволяє приймати будь-яку кількість показників для прогнозу й складнішу структуру помилок.

Регресія Демінга еквівалентна методу максимальної правдоподібності моделі похибок у змінних, в якій похибки для двох змінних вважаються незалежними й нормально розподіленими, та відомо співвідношення їхніх відхилень, позначених δ.[1] На практиці це співвідношення можна оцінити з відповідних джерел даних; проте процедура регресії не враховує можливі похибки при оцінці цього співвідношення.

Регресію Демінга лише трохи складніше обчислити в порівнянні з простою лінійною регресією. Більшість статистичних програмних пакетів, що використовуються в клінічній хімії, пропонують регресію Демінга.

Модель спочатку була введена Адкоком (1878), який розглядав випадок δ = 1, а потім більш загалом Куммел (1879) з довільним δ. Проте їхні ідеї залишалися значною мірою непоміченими понад 50 років, поки їх не відродив Коопманс (1937). Пізніше ще більше пропагував Демінг (1943). Остання книга стала настільки популярною в клінічній хімії та суміжних областях, що цей метод навіть був названий регресією Демінга в цих областях.[2]

Уточнення ред.

Припустимо, що наявні дані (yi, xi) є виміряними спостереженнями «істинних» значень (yi*, xi*), які лежать на лінії регресії:

де помилки ε та η незалежні, а відношення їх відхилень вважається відомим:

На практиці відхилення параметрів та часто невідоме, що ускладнює оцінку . Зверніть увагу, що коли метод вимірювання для та є однаковим, ці відхилення, ймовірно, також будуть однаковими, тому для цього випадку.

Ми прагнемо знайти таку лінію «найкращого підходу»,

де зважена сума квадратних залишків моделі зведена до мінімуму:[3]

Дивись Jensen (2007)[4] для повного виведення.

Рішення ред.

Рішення може бути виражено через моменти вибірки другого ступеня. Тобто спочатку обчислюємо наступні величини (всі суми йдуть від i = 1 to n):

Нарешті, оцінки найменших квадратів параметрів моделі будуть[5]

Ортогональна регресія ред.

Для випадку рівних відхилень похибки, тобто коли , регресія Демінга стає ортогональною регресією: вона мінімізує суму квадратів перпендикулярних відстаней від точок даних до лінії регресії. У цьому випадку позначимо кожне спостереження як точку zj в комплексній площині (тобто, точка (xj, yj) записується як zj = xj + iyj, де i — уявна одиниця). Позначимо як Z суму квадратичних відмінностей точок даних від центроїда (також позначається в комплексних координатах), яка є точкою, горизонтальними та вертикальними розташуваннями якої є середні значення цих точок даних. Тоді:[6]

- Якщо Z = 0, то кожна лінія через центроїд є лінією з найкращим ортогональним підходом.

- Якщо Z ≠ 0, лінія ортогональної регресії проходить через центроїд і паралельна вектору від початку до .

Тригонометричне представлення лінії ортогональної регресії було дано Кулідж в 1913 році.[7]

Додаток ред.

У випадку трьох не колінеарних точок у площині трикутник з цими точками, як його вершини, має унікальний еліпс Штайнера, дотичний до сторін трикутника в їхніх серединах. Велика вісь цього еліпса падає на ортогональну лінію регресії для трьох вершин.[8]

Див. також ред.

Примітки ред.

Список літератури ред.

- Adcock, R. J. (1878). A problem in least squares. The Analyst. Annals of Mathematics. 5 (2): 53—54. doi:10.2307/2635758. JSTOR 2635758.

- Coolidge, J. L. (1913). Two geometrical applications of the mathematics of least squares. The American Mathematical Monthly. 20 (6): 187—190. doi:10.2307/2973072.

- Cornbleet, P.J.; Gochman, N. (1979). Incorrect Least–Squares Regression Coefficients. Clin. Chem. 25 (3): 432—438. PMID 262186.

- Deming, W. E. (1943). Statistical adjustment of data. Wiley, NY (Dover Publications edition, 1985). ISBN 0-486-64685-8.

- Fuller, Wayne A. (1987). Measurement error models. John Wiley & Sons, Inc. ISBN 0-471-86187-1.

- Glaister, P. (2001). Least squares revisited. The Mathematical Gazette. 85: 104—107. doi:10.2307/3620485.

- Jensen, Anders Christian (2007). Deming regression, MethComp package (PDF).

- Koopmans, T. C. (1937). Linear regression analysis of economic time series. DeErven F. Bohn, Haarlem, Netherlands.

- Kummell, C. H. (1879). Reduction of observation equations which contain more than one observed quantity. The Analyst. Annals of Mathematics. 6 (4): 97—105. doi:10.2307/2635646. JSTOR 2635646.

- Linnet, K. (1993). Evaluation of regression procedures for method comparison studies. Clinical Chemistry. 39 (3): 424—432. PMID 8448852.

- Minda, D.; Phelps, S. (2008). Triangles, ellipses, and cubic polynomials (PDF). American Mathematical Monthly. 115 (8): 679—689. MR 2456092.[недоступне посилання з липня 2019]